אפל הכריזה אתמול על מספר תכונות של iOS 15 / iPadOS 15 בנוגע להגנה על ילדים מפני התעללות מינית. אלה האחרונים, לעומת זאת, מספקים כמה הבהרות (ועוד בטח יגיעו).

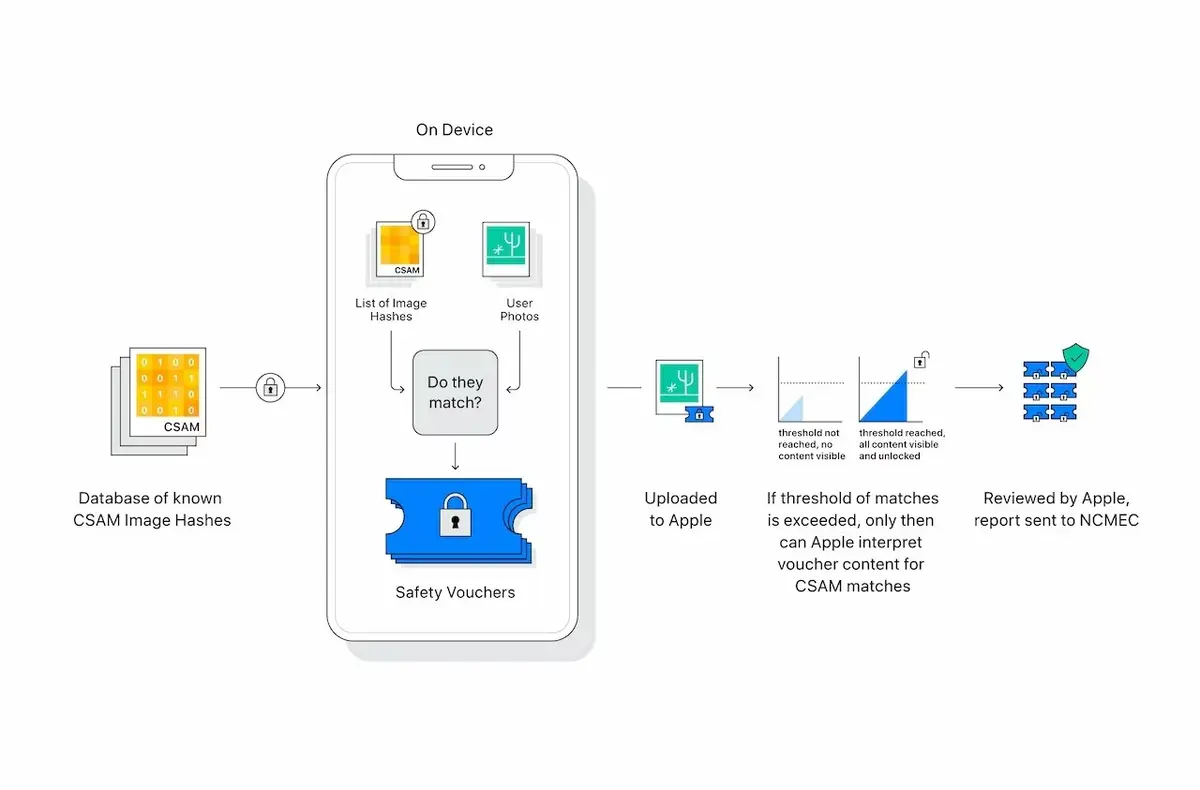

הראשון נוגע למנגנון CSAM (עבורחומר התעללות מינית בילדים

, כלומר היכולת לזהות תוכן פדופילי), מה שלאיתמקד כרגע רק באייפוןetאייפדאמריקאים. אפל לא מזכירה פריסה כרגע, אבל זה לעולם לא יכול להיות המקרה בהתחשב במספר המכשירים הנוגעים בדבר או פשוטהבדלים בחקיקה במדינות.

לגבי הטכניקה שלבְּלִיל, הוא מציין שהמכשירים ישתמשו בפועלאלגוריתמים מדויקים מאוד עם מסד נתונים בלתי קריא של hashes ידועים(לכן מזוהה בבירור כתוכן פדופיל) ויבצע השוואה במכשיר עם התמונות של המשתמש עצמו, ותסמן אותן לפני העלאתן לתמונות iCloud.

אם המשחק יצליח,התמונה תקבל סמן ספציפי.לאחר מספר מסוים, צוות אנושי יאמת ויחיל נוהל ספציפי, הכולל ביטול הפעלה של החשבון ויידע את המרכז המורשה (המרכז הלאומי לילדים נעדרים ומנוצלים).

יתר על כן, קופרטינומְאוּשָׁרפעם נוספתאין גישה לאייפוןאלא רק לתמונות המתארחות ב-iCloud. לכן, די בכךאל תפעיל את ההגדרהב-הגדרות>מזהה אפל>iCloud>תמונותלשםלִברוֹחַ.