אפל עומדת בפני תביעה מתוקשרת, המבקשת פיצויים בסך 1.2 מיליארד דולר, בגין נטישת תוכניתה השנויה במחלוקת לסריקת תמונות iCloud לאיתור חומרי ניצול מיני של ילדים (הידועה גם בראשי התיבות CSAM).

תביעה משפטית לאופציה שמעולם לא נפרסה!

אבל נראה שקובץ ה-CSAM עדיין לא הוחזק בארכיון עם ניסוי זה, מה שמעלה שאלות מורכבות לגבי האיזון בין פרטיות המשתמש להגנה על ילדים באינטרנט.

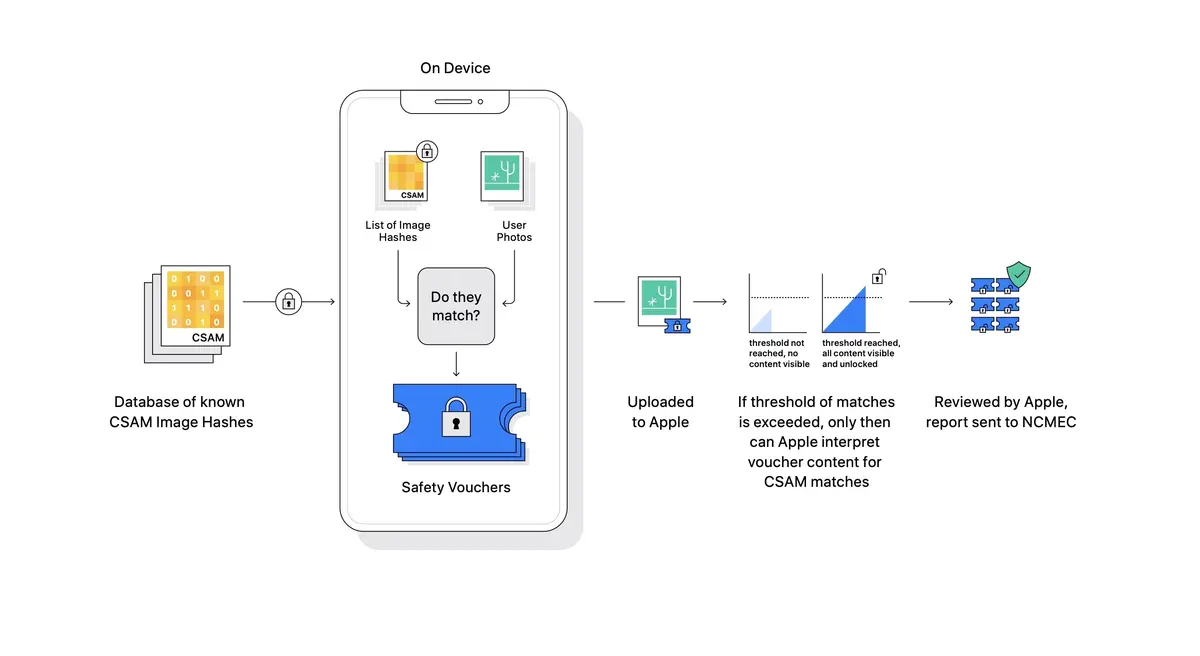

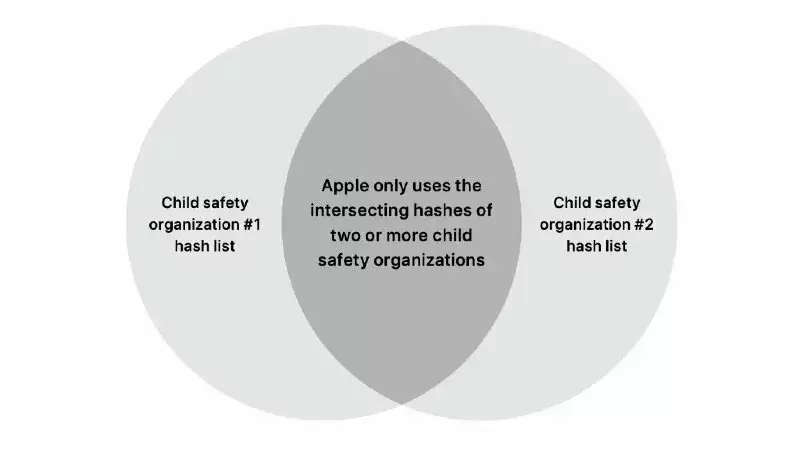

לשם כך, עלינו לחזור למקור הפונקציה. באוגוסט 2021,החברה הקליפורנית הייתה מאודמתח ביקורתבמהלך הצגת מערכת ה-CSAM שלה -Child Sexual Abuse Material- והיא נאלצה להשעות את יישומה בדצמבר.באותה תקופה, היא הסירה בשיקול הדעת הגדול ביותר את כל האזכורים הקשורים ל-CSAM, ואישרה את המחלוקת סביב האמצעים הצפויים.

בעולם,אלה היו תכונות בפלטפורמות שלה שמטרתן להגן על ילדים, כולל מערכת המסוגלת לזהות תוכן פורנוגרפי לילדים ב-iCloud תוך שמירה על פרטיות המשתמש. אלה קיבצו שלושה תחומים: iMessage, Siri, iCloud. שם מהר מאודסריקת אייפון

, התכונה עוררה זעקה של התנגדות מצד משתמשים, פקידים וחוקרי אבטחה.

מול ביקורת, אפל דחתה תחילה, ואז ביטלה את הפרויקט הזה.ההחלטה נבעה מחששות לגבי אבטחה, פרטיות המשתמש והסיכון של ניצול טכנולוגיה זו לסוגי מעקב אחרים.

מה הדרישות?

התביעה מוגשת בשם 2,680 קורבנות פוטנציאליים להתעללות, בטענה שאפל אפשרה לתוכן CSAM להמשיך להסתובב באינטרנט. עבור התובעת הראשית, הגשה תחת שם בדוי (זה אפשרי בארה"ב), חוסר המעש של אפל היה מאריך את הטראומה שלה בכך שהוא מאפשר לתמונות של ניצול העבר שלה להישאר נגישות.

בסך הכל, התובעים טוענים כי על ידי נטישת כלי זיהוי ה-CSAM שלה, אפל כשלה בחובתה להגן על ילדים ונפגעי התעללות. ולכן, זההכישלון בפריסת הטכנולוגיה הזו ב-iCloud Photos תרם ישירות להפצת תוכן מזיק.

מצדו,אפל אישרה מחדש את מחויבותה להגן על ילדים, תוך הגנה על בחירתה שלא להציג טכנולוגיה שעלולה לסכן את פרטיות המשתמשים.לפיכך, המשרד הדגיש את הכלים הנוכחיים שלה, כמו פונקציית אבטחת התקשורת כדי להזהיר ילדים מפני תוכן שעלול להיות בלתי הולם.

סיכון גדול מדי לחיסיון הנתונים

לאחר החלטתה לא לפרוס את הפונקציה הזו, אפל באה להסביר יותר, בתגובה לפניית העמותהיוזמת חום, וזה, דרך אריק נוינשוונדר (מנהל פרטיות המשתמש ובטיחות ילדים של אפל).

התעללות מינית בילדים היא מעשה מתועב ואנו מחויבים לשבור את שרשרת הכפייה וההשפעה שמותירה ילדים פגיעים. [...] דיגיטציה של נתוני iCloud המאוחסנים עבור כל משתמש בודד תיצור וקטורי איומים חדשים שגנבי נתונים יוכלו למצוא ולנצל[...] זה עלול להוביל אותנו במדרון חלקלק עם השלכות לא רצויות. חיפוש אחר סוג אחד של תוכן פותח את הדלת למעקב המוני ועלול לבקש ממך לבדוק מערכות הודעות מוצפנות אחרות.

(Erik Neuenschwander, מנהל פרטיות המשתמש ובטיחות ילדים של אפל)

במילים אחרות אחרי שישלשים את האינטרסים במאזן, ההתערבות בפרטיות והסיכון לפריצת נתונים (ובכך החלישו את האבטחה הקדושה של אפל) היו גדולים מדי. לכן היה צורך למצוא אמצעי אחר למאבק בפורנוגרפיית ילדים. כמו כן, היא סיכמה את זהזה לא יכול היה להמשיך בפיתוח של מנגנון ניתוח כמו ה-CSAM.

תגובה זו מגיעה בתקופה מתוחה שבה הדיון בהצפנה הועלה מחדש על ידי ממשלת בריטניה. האחרונה מתכננת לשנות את המשטר המשפטי שלה כדי לאלץ חברות טכנולוגיה לבטל תכונות אבטחה כגון הצפנה מקצה לקצה, מבלי ליידע את המשתמשים (בתנאים מסוימים). בתנאים אלה, אפל הבהירה כי היא תפסיק את שירותיה, לרבות FaceTime ו-iMessage, בבריטניה אם חוק כזה יאומץ במתכונתו הנוכחית.